SEO

更新日2024年07月25日

公開日2023年5月1日

クロールバジェットとは?大規模サイトのSEOやGoogleの見解を解説

Web上には、膨大な数のコンテンツが存在します。

それらコンテンツを、Googleは常にクロールしていますが、そのすべてを際限なくクロールできるわけではありません。

そのため、Webサイトごとにおけるクロールにも限度があるといえます。

このWebサイトごとに、クロールをしてもらえる頻度やリソースといった概念は「クロールバジェット(クロールの割り当て)」と一般的に表現されます。

そして言及されるのが、クロールバジェットの問題。

クロールバジェットの問題とは、割り当ての上限によってクロールが制限されてしまい、ページがインデックスされないといったものです。

この記事ではそんな、クロールバジェットの影響を受けるWebサイトや最適化の方法をお伝えします。

最後までお読みいただくことで、クロールバジェットに関する近いが深まり、インデックス問題が解消されるでしょう。

大手企業も続々導入中!

多機能型 検索順位チェックツール「Nobilista(ノビリスタ)」

Nobilistaは、365日完全自動で大量の検索キーワードの順位を計測するSEOツールです。

※7日間の無料トライアル実施中

Googleにインデックスされない原因別の対策方法を解説!クローラーが来ない問題の解決方法やインデックスを促進する方法とは

クロールバジェットとは

クロールバジェットとは、各Webサイトにおけるクロールのための時間やリソースの配分であり、一般的に「クロールの上限」を意味する言葉です。

クロールバジェットが問題視される理由は、その上限を超えることでクロールが制御され、インデックスがされなくなることにあります。

Google がサイトのクロールに費やす時間とリソースは、通常、サイトのクロールの割り当てと呼ばれます。

引用:Google

ちなみに、本来「バジェット(budget)」とは、予算や経費という意味。

つまり、Googleからクロールのための予算(経費)を割り振ってもらっていると考えると、イメージしやすいかもしれません。

ここからはもう少し、クロールバジェットの役割や仕組みについて、深掘りをしていきたいと思います。

インデックスとは?SEOとの関係や確認方法、登録方法を解説

クロール(クローラー、Googlebot)とは

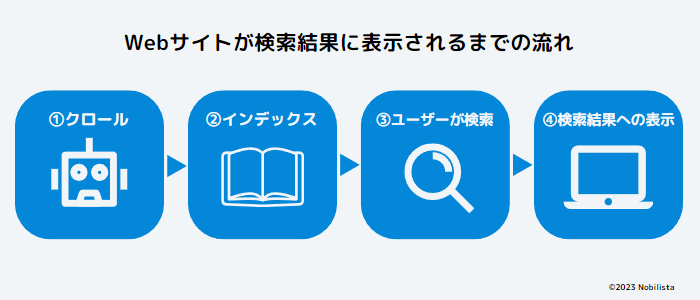

あらためて、クロール(クローラー)について触れておきましょう。

まず、クローラーとは、Webサイトへ訪れてその内容を読み取り、コンテンツの内容確認と収集をおもに行うプログラムです。

Googleのクローラーは「Google bot(グーグル ボット)」とも呼ばれています。

そして、このクローラーにWebサイトへ来てもらい、内容を読み取ってもらう行為が「クロール」です。

クローラーとは?意味や仕組み、巡回を促す対策、拒否する方法をわかりやすく解説

クロールバジェットの役割

クロールバジェットのおもな役割は、サーバーに負荷をかけないよう制御することです。

クロールを行うときの状況をわかりやすく表現すると、Webサイトの情報を格納しているサーバーにクローラーが「このWebサイト見たいから情報送ってよ」とリクエストする感じだとイメージしましょう。

このリクエストの際に、サーバーには多少の負荷がかかってしまいます。

たとえば、アクセス数が集中してWebサイトがダウンしてしまうといった話も、大量のアクセス(リクエスト)によってサーバーに負荷がかかってしまったためです。

そして、サーバーに負荷がかかるというのは、ほかの人のサーバー接続、つまりサイト接続にも影響を与えます。

そこでGoogleは、クロールによってサーバーに負荷がかからないように、ひいてはユーザーが快適にWebサイトへ接続できるように、状況によってクロールを制御するアルゴリズムをクローラーに組み込んでいます。

Googlebot には、クロール中にサイトが過負荷にならないようにするアルゴリズムがあります。

引用:google

クロールバジェット(割り当て)はどう決まる?

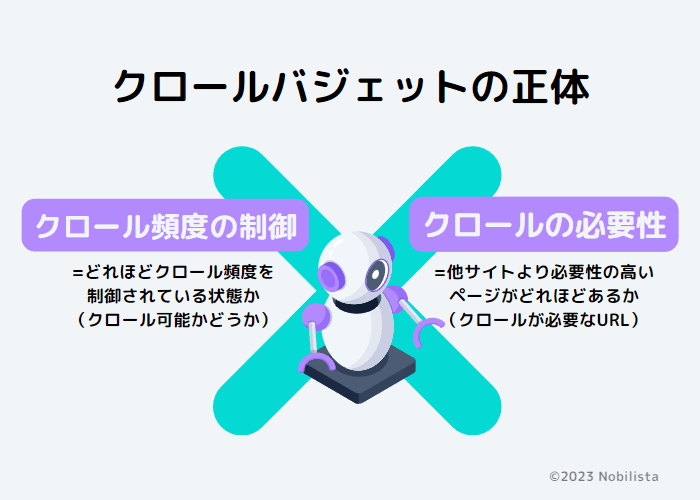

クロールバジェットはおもに「クロール頻度の制御」と「クロールの必要性」の2つの要素によって決まります。

クロール頻度の制御

さきほども話したとおり、クロールバジェットにはサーバーに負担をかけないよう、クロール頻度の制御を行うプログラム(計算)が組み込まれています。

この計算は「Webサイトへ同時に接続できる最大数」と「サーバーの応答にどれだけ時間がかかったか(遅延したか)」で行われます。

Googlebot では、負担をかけないためのクロール能力の上限を計算します。

引用:Google

計算では、Googlebot でサイトのクロール時に使用可能な同時並行接続の最大数と、次回の取得までに必要な待ち時間が考慮されます。

また、サーバーに過負荷をかけずに重要なコンテンツ全体をカバーするように配慮されます。

また、クロール頻度の制御は、計算以外にもさまざまな要素によって行われます。

| クロールの状態 | Webサイトの応答速度が良好だとクロール頻度が上がり、応答速度が遅くなり始めると頻度が下がる。 |

| Googleサーチコンソールの設定 | Googleサーチコンソールの設定で、クロールの頻度を減らし、制限することができる。 |

| Googleのクロール上限 | 単純にGoogleのクロールにおけるリソースの限界。 |

クロールの必要性

クロールバジェットは「クロールの必要性」によっても左右されます。

Googleは基本的に、以下の項目を考慮しつつ、そのうえでほかのWebサイトと必要性を比較します。

- サイト規模

- 更新頻度

- ページ品質

- 関連性

そして必要と判断した分だけ、クロールに時間をかけます。

つまり、必要性によって特定のWebサイトのクロールを優遇することがあるようです。

クロールの必要性を左右する要素には、とくに以下のようなものがあります。

| ①検出されたすべてのURL | インデックスの必要性があきらかに低い重複コンテンツや削除済みページ、低品質コンテンツ、スパムコンテンツは、クロールの必要性もまた低いため、クロール頻度が下がっていく。 また、上記のようなインデックスに適さないコンテンツのクロールに時間がかかっていると、Webサイトの残りすべてのURLをクローラーが無視することもある。 |

| ②人気度 | Web上で人気のコンテンツは、需要がある分ユーザーのために最新の情報を反映しなくてはいけない。 そのため、クロールの必要性が高くなる。 |

| ③更新頻度(古さ) | 更新頻度をモニタリングしたうえで、更新頻度が低いものは、クロールの必要性を低くする。 ただし、しばらくクロールしていないものはインデックスのデータを最新のものにするため、古いコンテンツでも必要性が高くなる場合もある。 |

また、サイトの移転のように、大量にインデックスをしなおさなければならない状況でも必要性は高くなるようです。

重複コンテンツを避ける方法とは?判定基準や原因別の対策方法、SEOへの影響を解説

クロールバジェットに対するGoogleの見解

Googleも公式ガイドラインで当たり前に使っているクロールバジェットですが、実は、そもそもGoogleにはなかった概念といわれています。

SEO界隈で生まれて広がったようですが「クロールには上限がある」という定義が独り歩きした結果、ついにはGoogleが公式的に言及をすることに。

昨今、「クロールの割り当て」についてさまざまな定義を耳にします。

引用:Google

しかし、Google の外部で「クロールの割り当て」が表すあらゆるものを一言で説明できるような言葉はありません。

つまり「クロールの上限を設定する」ような、単独のプログラムはGoogleにはないという意味でしょう。

Googleから各Webサイトに対してクロールを配分するような仕組みも、クロールに上限が設定されていることも、実はなかったわけです。

さらにGoogleは、クロールバジェットの概念に近い現象を起こす要素を挙げて、公式的に定義をつけました。

それが以下です。

こうしたクロール能力とクロールの必要性を併せて考えると、サイトに対するクロールの割り当ては、Googlebot によるクロールが可能であり、かつクロールが必要な URLセットであると定義できます。

引用:Google

Googleはクロールバジェット(割り当て)の定義を「クロールが可能で、クロールの必要があるURLの数」としました。

ちょっとピンと来ない方もいるかもしれません。

つまり、さきほど紹介した「クロール頻度の制御」と「クロールの必要性」による、クロール頻度の変動に過ぎなかったのです。

補足として、2つの要素を「クロールバジェットが決まる要素」と説明しましたが、このように実際のところは、2つの要素によってクロールバジェットという概念が生まれたといった方が正しいでしょう。

現在はGoogleがクロールバジェットを定義づけしたことで、その要素として公式的に紹介されています。

話を戻すと、この2つの要素によって、ただクロールが制限されているように見えたというのが、クロールバジェットの正体だったということです。

クロールバジェットという言葉は「クロールバジェットの節約をする」「クロールバジェットが無駄になる」といった使われ方をよくされます。

ただ、何かプログラムによってWebサイトごとにクロールの上限数が割り振られているというわけでも、クロールによってその数が減っていくというわけでもありません。

いまGoogleも分かりやすい表現のため「クロールバジェット」という言葉を使っていますが、その実態は違うことをぜひ知識として覚えておきましょう。

クロールバジェットの影響を受けるサイト形態

基本的にクロールバジェットの影響を受けるWebサイトはほとんどありません。

ただし、以下のようなWebサイトで、クロールが来ないなど問題が起こっている場合。

原因のひとつとして、クロールバジェットを視野にいれてもいいかもしれません。

- 大規模サイト(100万ページ以上)+更新頻度は「週1回以上」

- 中規模サイト(1万ページ以上)+更新頻度は「ほぼ毎日」

- パラメータなどの大量の自動生成ページを持つWebサイト

- 大量のリダイレクト(とくにリダイレクトチェーン)があるWebサイト

いくつか補足すると、まず「パラメータ」とは、URLの末尾に「?(はてな)」がついているページです。

たとえば、ECサイトで多く使われる、商品のソート機能やフィルタ機能は、このパラメータによって自動で生成されます。

_改-min.png)

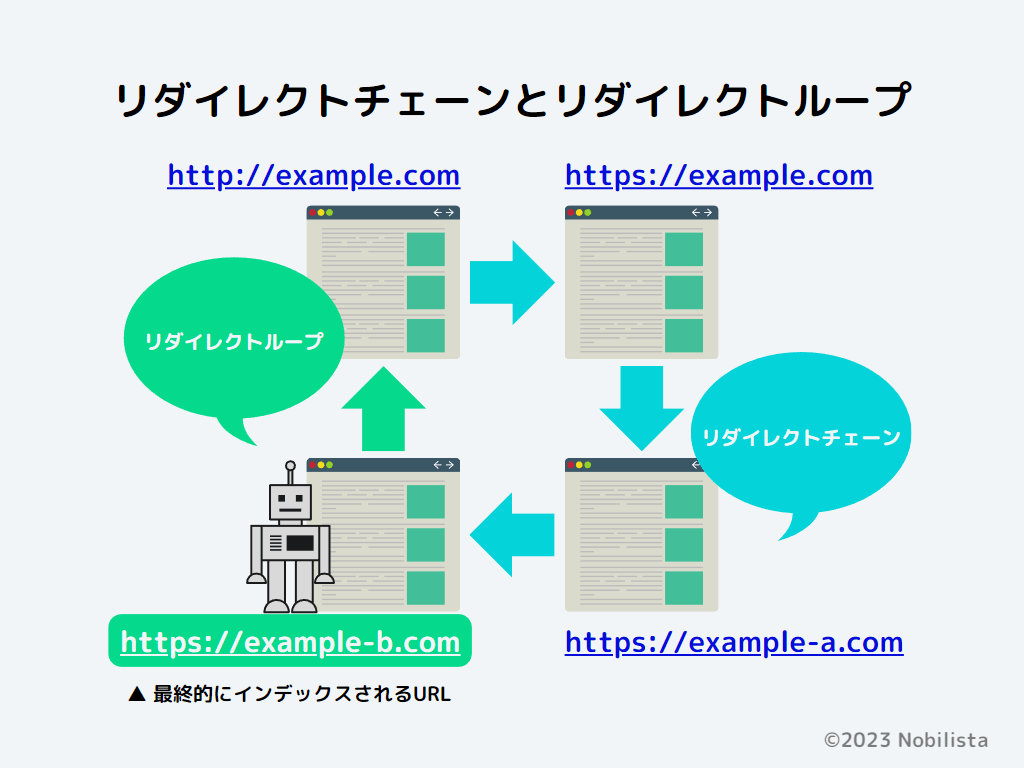

そして「リダイレクトチェーン」とは、文字どおり、リダイレクトがチェーンのように連なって続くことです。

リダイレクトチェーンが続いてしまうこと自体、悪いことではありません。

ただし、それが過剰かつ大量になると、クロールバジェット問題を引き起こす可能性があります。

そのため、できる限りリダイレクトチェーンは避けたほうがよいでしょう。

ちなみに、リダイレクトチェーンの最後に、すでにリダイレクトをしているページにさらにリダイレクトされ、ループになっている状態を「リダイレクトループ」といいます。

より具体的に、クロールバジェットの可能性が考えられるWebサイト(コンテンツ)の例はこちら。

- 大規模なニュースサイト

- 更新が頻繁・ページがよく追加される業種サイト(賃貸物件の掲載を扱う不動産サイトなど)

- ユーザー生成コンテンツ(Yahoo知恵袋のようなQ&Aサイト、掲示板サイト)

- 製品の数が多く、フィルタ・ソート機能が豊富な大型ECサイト

上記のようなWebサイトで、クローラーが来ていなかったり、ほとんどのページがGoogleサーチコンソールで「検出- インデックス未登録」に分類されていたりしたら、次で紹介する「クロールバジェットの最適化」をぜひ検討してみてください。

301リダイレクトとは?設定方法・確認方法やSEOとの関係、.htaccessの書き方を解説

クロールバジェット最適化の方法

もしWebサイトがクロールバジェットの影響を受けていたり、その可能性が考えられたりしたら、以下のクロールバジェットの最適化を試してみましょう。

基本的な最適化の考え方は「いかに不要なクロールを減らせるか」と「いかにクローラーの処理能力やクロール効率を高められるか(阻害するものを取り除けるか)」だといえます。

- 「robots.txt」でクロールが不要なページを除外する

- 不要なページは削除する(404や401ステータスコード設定の併用)

- 過剰なリダイレクトチェーンは避ける

- 重複コンテンツの正規化

- ページの読み込み速度の改善

- 内部リンクの設置などクローラビリティの改善

- サーバーのスペックを変えてみる

「robots.txt」でクロールが不要なページを除外する

ページは存在したほうがよい(削除できない)けど、検索結果に表示させるは必要はない(=クロールの必要はない)。

このようなページやコンテンツは「robots.txt」を使用してクロールしないよう設定しましょう。

robots.txt を設定するページには、以下の例があります。

- マイページや管理画面といった「認証が必要なページ」

- フィルタ・ソート機能など自動生成ページ

- ECサイトのショッピングカートページ

- 会員登録やログイン画面などの入力ページ

robots.txt のくわしい書き方や設定方法は、以下をご覧ください。

robots.txtの書き方と設定方法|実際の使用ケースや記述例も紹介

不要なページは削除する

不要なページは、事前に削除をおすすめします。

とくに、質の低いコンテンツやスパムコンテンツは、Webサイト全体のSEOに影響を与えるため注意しましょう。

たとえば、Google検索アルゴリズムには「ヘルプフル コンテンツ システム」というものがあります。

独自性のある、ユーザーファーストなコンテンツを評価するアルゴリズムですが、こちらは低品質のコンテンツがWebサイト全体に多いと、質の高いコンテンツを作っても評価されづらいといった影響範囲の広いアルゴリズムです。

こういったGoogleアルゴリズムを考えても、不要なページは極力削除するようにしましょう。

また、Googleはさらに、削除したページに対して「404(Not Found)」や「401(Unauthorized)」のステータスコードを設定するよう推奨しています。

これらはクロールをしないよう強く求める意味があるのと同時に、インデックス削除を求める意味もあるためよく検討して使うべきです。

Googleアルゴリズムとは?仕組みやランキング要因、アップデートの歴史を解説

過剰なリダイレクトチェーンは避ける

リダイレクトチェーンの説明でも言ったとおり、あまりにもリダイレクトの数が過剰な場合は対処を検討すべきでしょう。

また、日ごろ管理やリスクの点から、安易にリダイレクトは行わないことをおすすめします。

重複コンテンツの正規化

重複コンテンツとは、内容が似通っているコンテンツが複数ある状態。

もしくは、同じページにさまざまなURLでアクセスできる状態を指します。

似通っているコンテンツは、記事の内容が似ているという意味のほかに、パラメータなどの自動生成ページや外部サイトがコピーコンテンツを作ることも、ある意味で重複コンテンツに当てはまります。

そして、Googleはすべてのコンテンツをかならずインデックスするわけではありません。

つまり、似ているコンテンツなどは、どれかひとつに決めてインデックスをします。

このインデックスするコンテンツを選ぶ行為が「正規化」です。

正規化は、基本的にGoogleが適したコンテンツを選んで行ってくれます。

ただ、ときには正規化してほしいコンテンツを選んでくれなかったり。

正規化がされないこともあるため、適宜確認するようにしましょう。

重複コンテンツの具体的な対策については、以下の記事をご覧ください。

重複コンテンツを避ける方法とは?判定基準や原因別の対策方法、SEOへの影響を解説

ページの読み込み速度の改善

ページの読み込み速度が速くなれば、その分クローラーがコンテンツの情報を読み取る量も増えます。

つまり、クロール効率を高めることにつながるのです。

クロール効率が高まると、クロールバジェットにも効果が期待でき、また「コア ウェブ バイタル(Core Web Vitals)」の観点からもおすすめといえるでしょう。

Webサイト表示速度の改善方法とは?読み込みスピードを計測するツールや数値の目安を紹介

内部リンクの設置などクローラビリティの改善

クローラビリティとは、簡単にいうとWebサイトにおけるクロールのしやすさです。

クローラーは、リンクを通してWebサイトを回遊しています。

そのため、内部リンクが少なかったり、サイト構造が複雑だったりすると、クローラビリティも下がり、クロール効率に影響が出てくるでしょう。

クローラビリティとは?SEOにおける重要性や改善方法、状況確認の方法を紹介

サーバーのスペックを変えてみる

サーバー側のエラーによって、クロールバジェットが頻繁に制御されている様子があるなら、サーバーをよりスペックの高いものへと変更するのもひとつの手です。

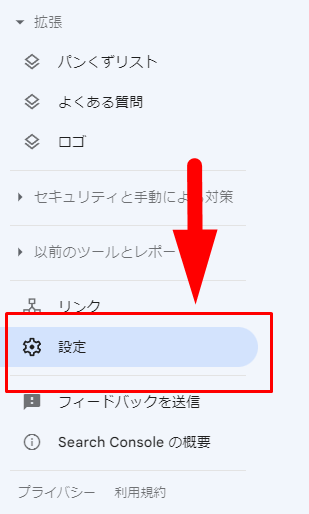

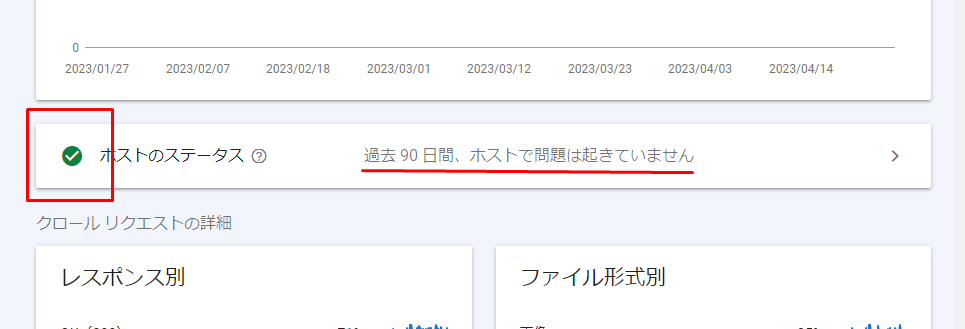

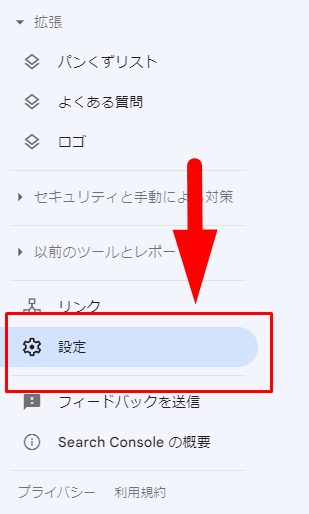

▼Googleサーチコンソール「クロールの統計情報」でサーバー側のエラーを見る方法

- Googleサーチコンソールの「設定」を選ぶ

- 「クロールの統計情報」の「レポートを開く」から入る

- 「ホストステータース」の部分が問題ないか、緑色マークかどうか確認する

- さらに「>」から入ることで、よりくわしい状態を見ることができる

Googleサーチコンソールでクロール頻度やクロール日を確認する方法

ここではGoogleサーチコンソールで「クロール頻度」と「クロールされた日」の確認方法を紹介します。

クロール頻度(リクエスト)の確認方法

Googleサーチコンソールでのクロール頻度、厳密にいえば「クロールのリクエスト数(クロールするためにサーバーに情報を求めた回数)」を確認する方法は以下です。

の確認方法.png)

折れ線グラフは、クローラーがリクエストをした回数です。

あきらかに異常な動きをしていたら、注意するとよいでしょう。

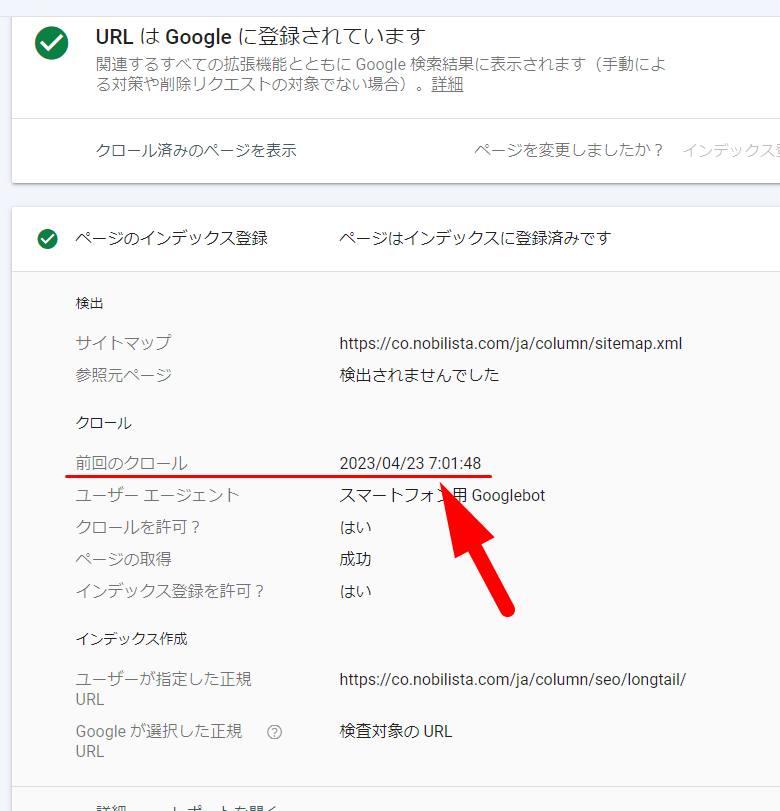

クロールされた日はいつか確認する方法

特定のページが、直近のいつにクロールされたか。

こちらもGoogleサーチコンソールで調べることができます。

「URL検査」またはGoogleサーチコンソールの上部に調べたいコンテンツのURLを入力しましょう。

「前回のクロール」に書かれている日付が、直近でクロールした日です。

Googleサーチコンソールとは?できることや使い方、登録方法・設定方法を解説

クロールバジェットに関するよくある質問

クロールバジェットに関するよくある質問についてお話ししましょう。

- Googlebotは「Crawl-delay」で制限できる?

- クローラーが来ない・インデックスされないのはクロールバジェットの問題?

- クロールバジェットを増やす方法は?

「Crawl-delay」でGooglebotは制限できる?

「Crawl-delay」とは、robots.txt などで使う、クロールにおけるリクエスト頻度(間隔)を設定するためのもの。

ただし、Googleでは使えないルールのため注意しましょう。

クローラーが来ない・インデックスされないのはクロールバジェットの問題?

「クローラーが来ない」「インデックスされない」の原因のなかでもクロールバジェットがかかわることはほとんどありません。

その他の原因としては、以下のようなものが挙げられます。

- 内部リンクがないためクローラーが来られない

- コンテンツがrobots.txtでブロックされている

- サーバーのスペックが弱い

クロールが来ない、インデックスがされないとお悩みの方は、以下の記事でその他の「11の原因」を徹底解説しています。

よくあるインデックスされないときの勘違いやインデックスを調べる方法など、お役に立つ情報を「総まとめ」したのでぜひご覧ください。

Googleにインデックスされない原因別の対策方法を解説!クローラーが来ない問題の解決方法やインデックスを促進する方法とは

クロールバジェットを増やす方法は?

クロールバジェットを増やすには「クロールの処理能力」と「良質なコンテンツ作り」が必要です。

良質なコンテンツは、クロールバジェットの要素「クロールの必要」のなかの「人気度」にも影響します。

良質なコンテンツはSEOのどのシーンでも重要となる部分なので、ぜひ意識しましょう。

良質なコンテンツとは何か?Googleの定義や作り方のポイントを解説